Outils de scraping : Notre classement des meilleurs outils en 2025

Découvrez les top outils pour collecter des données sur le web

7/11/2025

6 min

de lecture

Thomas Groc

Collecter des données sur le web, c’est devenu une habitude pour beaucoup d’entreprises. Que ce soit pour surveiller la concurrence, suivre les prix ou alimenter une base de données, le web scraping est devenu un levier clé. Mais encore faut-il choisir le bon outil.

Certains privilégient la simplicité, d’autres la puissance ou la capacité à gérer de gros volumes. Et entre les options no-code, les solutions open source ou les plateformes tout-en-un, le choix peut vite devenir flou.

Alors quels sont les meilleurs outils de scraping ? L’école Cube vous propose son classement.

Classement des outils de scraping - à retenir

Octoparse pour transformer des milliers de pages en données structurées

Besoin de collecter des données web sans coder ? Octoparse est sans doute le point de départ idéal. Cet outil de scraping visuel transforme n’importe quelle page web en tableur exploitable, sans passer par la moindre ligne de code.

L’interface fonctionne sur le principe du “pointer-cliquer” : on sélectionne les éléments à extraire (titres, prix, images, liens…) et Octoparse se charge du reste.

L’un de ses grands atouts réside dans ses modèles prêts à l’emploi : Amazon, LinkedIn, Indeed ou encore Booking sont déjà configurés pour extraire des données en quelques clics.

Pour les utilisateurs plus avancés, le logiciel propose aussi des options de planification, de rotation d’IP et d’exécution dans le cloud. On peut ainsi automatiser des tâches à grande échelle sans dépendre de son ordinateur.

Ce qu’on aime ? L’interface intuitive et les nombreux templates qui simplifient la mise en route.

Ce qu’on aime moins ? La version gratuite devient vite limitée si l’on veut scraper plusieurs sites ou gros volumes.

Prix ? Gratuit jusqu’à 10 000 lignes de données, puis à partir de 69 € /mois pour les formules payantes.

Scrapy, le meilleur outil de scraping open source

Scrapy s’adresse aux utilisateurs plus techniques qui veulent garder la main sur tout le processus de scraping. Ce framework open source, développé en Python, est une référence dans le domaine depuis plusieurs années.

Il offre une structure complète pour extraire, traiter et stocker des données issues du web, tout en respectant les bonnes pratiques (robots.txt, délais entre requêtes, etc.).

Contrairement aux outils visuels, Scrapy demande un peu de programmation, mais cette exigence s’accompagne d’une flexibilité totale. On peut personnaliser les règles d’extraction, automatiser la navigation entre les pages, gérer les erreurs, ou encore intégrer des proxys et des headers dynamiques pour passer sous les radars des sites protégés.

C’est l’outil idéal pour les développeurs, chercheurs ou data analysts qui travaillent sur des projets complexes ou volumineux.

Ce qu’on aime ? Sa puissance et sa liberté de personnalisation pour les projets ambitieux.

Ce qu’on aime moins ? La courbe d’apprentissage un peu raide pour les non-développeurs.

Prix ? Entièrement gratuit et open source, ce qui en fait une option imbattable pour les utilisateurs expérimentés.

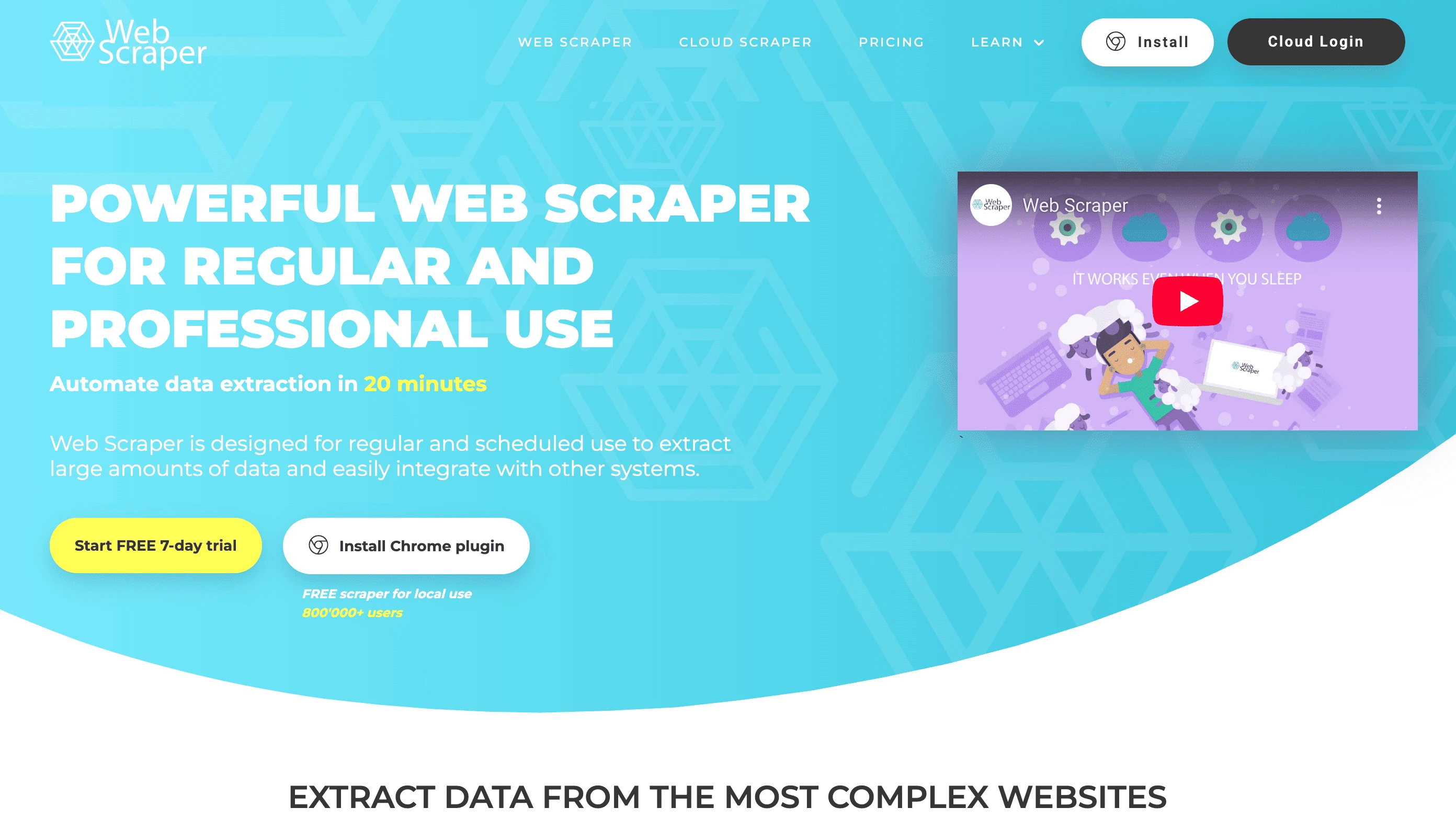

WebScraper.io, l’outil de scraping le plus intuitif

Pour ceux qui cherchent une solution simple et rapide, WebScraper.io fait partie des outils les plus accessibles du marché. Il s’agit d’une extension gratuite pour Chrome et Firefox qui permet d’extraire des données directement depuis le navigateur.

Une fois installée, il suffit de naviguer sur le site cible, de sélectionner les éléments à capturer (titres, prix, images, etc.), puis de lancer le scraping. En quelques minutes, les données sont exportées sous forme de CSV ou Excel.

L’un des gros avantages de WebScraper.io, c’est sa prise en main immédiate. Aucune compétence technique n’est requise, et les tutoriels intégrés guident les utilisateurs pas à pas. Pour aller plus loin, la version Cloud permet d’automatiser les extractions, de planifier les tâches et de stocker les résultats en ligne.

C’est un outil pratique pour la veille concurrentielle, la recherche produit ou la création de bases de données simples.

Ce qu’on aime ? Sa simplicité et la rapidité de mise en route pour les utilisateurs débutants.

Ce qu’on aime moins ? Les performances limitées sur les sites complexes ou dynamiques (JavaScript, pop-ups, etc.).

Prix ? Gratuit sur navigateur, avec une version Cloud payante à partir de 50 $/mois.

ParseHub, l’outil graphique qui simplifie le scraping des sites dynamiques

Quand il s’agit d’extraire des données sur des sites complexes ou interactifs, ParseHub fait partie des solutions les plus fiables.

Cet outil de scraping visuel fonctionne grâce à une interface graphique claire qui permet de sélectionner les éléments à extraire sans écrire de code.

Il se distingue surtout par sa compatibilité avec le JavaScript, AJAX et les sites dynamiques, souvent inaccessibles aux outils plus simples.

L’utilisateur configure son extraction via un système de “clics guidés” : chaque action sur la page (ouvrir un menu, cliquer sur un bouton, charger une nouvelle section) est enregistrée pour reproduire le comportement humain. ParseHub peut ensuite exécuter ces tâches automatiquement, que ce soit depuis un poste local ou dans le cloud.

C’est une solution idéale pour ceux qui ont besoin de collecter des données sur des plateformes dynamiques comme Amazon, Twitter ou Airbnb, sans passer par le code.

Ce qu’on aime ? Sa capacité à gérer les sites complexes grâce à la compatibilité JavaScript et au rendu visuel.

Ce qu’on aime moins ? Le traitement peut devenir lent sur les gros volumes de pages.

Prix ? Version gratuite disponible, puis à partir de 189 $/mois selon la fréquence et le volume d’extractions.

Apify, la plateforme tout-en-un pour automatiser le scraping et le crawling

Apify s’adresse à ceux qui veulent aller au-delà du simple scraping. Plus qu’un outil, c’est une plateforme complète d’automatisation web. Elle permet de créer, exécuter et gérer des “acteurs” (scripts d’extraction de données) capables de parcourir des sites, interagir avec des formulaires, ou encore collecter des informations à grande échelle.

Ce qui distingue Apify, c’est son écosystème ouvert : la marketplace propose des centaines de modèles déjà prêts, développés par la communauté. On y trouve des scrapers pour Google Maps, Amazon, LinkedIn ou Airbnb, qu’il suffit de personnaliser.

Pour les profils techniques, l’API et le SDK Apify permettent de créer des scripts sur mesure, en JavaScript ou Python, avec une intégration fluide vers d’autres outils (Zapier, Make, Notion, etc.).

C’est la solution idéale pour les entreprises ou freelances qui veulent automatiser leur veille ou alimenter leurs bases de données sans intervention manuelle.

Ce qu’on aime ? La marketplace d’acteurs prêts à l’emploi et l’intégration facile avec d’autres outils.

Ce qu’on aime moins ? Les nombreuses fonctionnalités peuvent paraître intimidantes au départ.

Prix ? Offre gratuite disponible, puis formules payantes à partir de 39 $/mois, selon le volume de requêtes et la puissance du serveur.

Bright Data, la solution professionnelle pour le scraping à grande échelle

Quand le scraping devient une activité stratégique, Bright Data (anciennement Luminati) s’impose comme une référence. C’est une solution professionnelle pensée pour les entreprises qui ont besoin de collecter de gros volumes de données en toute fiabilité.

L’outil repose sur une infrastructure de proxy mondiale qui permet d’accéder à des millions d’adresses IP, garantissant un contournement efficace des blocages et des captchas.

Bright Data intègre également une API performante pour automatiser le scraping et structurer les données. On peut extraire des informations en temps réel sur les prix, les avis, les produits ou encore les tendances de marché, tout en respectant les réglementations locales.

Les entreprises l’utilisent notamment pour la veille concurrentielle, l’analyse e-commerce ou la recherche académique à grande échelle.

Sa robustesse et sa fiabilité en font une solution incontournable pour les besoins avancés, mais son coût la réserve plutôt aux usages professionnels.

Ce qu’on aime ? Une qualité de scraping irréprochable grâce à son réseau mondial de proxys.

Ce qu’on aime moins ? Des tarifs élevés qui limitent son accès aux petites structures.

Prix ? Plans personnalisés selon le volume et le type de données collectées.

Le scraping n’est plus réservé aux développeurs. Aujourd’hui, chacun peut extraire et analyser des données web, à condition d’utiliser les bons outils. Mais pour aller plus loin - automatiser, structurer et exploiter ces données efficacement - il faut comprendre les bases de l’automatisation et de l’intelligence artificielle. C’est justement ce qu’enseigne l’École Cube

Découvrez les formations IA et automatisation de l’École Cube